PyTorch란?

- PyTorch는 페이스북(현 Meta)에서 개발한 딥러닝 프레임워크입니다.

- 마치 레고 블록처럼 신경망을 쉽게 조립하고 수정할 수 있게 해 줍니다.

CUDA Toolkit이란?

- CUDA(Compute Unified Device Architecture)는 NVIDIA에서 개발한 기술로,

그래픽 카드(GPU)를 이용해 복잡한 계산을 처리할 수 있게 해 줍니다. - CPU보다 GPU가 딥러닝과 같은 병렬 계산을 훨씬 빠르게 처리할 수 있기 때문에 중요합니다.

cuDNN이란?

- cuDNN(CUDA Deep Neural Network Library)은 NVIDIA에서 제공하는 딥러닝 전용 라이브러리입니다.

- 딥러닝에 자주 사용되는 연산(컨볼루션, 풀링 등)을 최적화해 속도를 크게 향상시킵니다.

설치 순서

- NVIDIA 드라이버 설치 (그래픽 카드 사용을 위한 기본 소프트웨어)

- CUDA Toolkit 설치 (GPU를 활용하기 위한 도구)

- cuDNN 설치 (딥러닝 성능 향상을 위한 라이브러리)

- PyTorch 설치 (딥러닝 프로그래밍을 위한 프레임워크)

- 가상환경 설정 (프로젝트별 독립된 파이썬 및 라이브러리 환경을 생성)

NVIDIA 드라이버 설치

먼저 자신의 데스크톱 또는 노트북의 그래픽카드(GPU) 드라이버가 설치되어 있는지 확인해야 합니다.

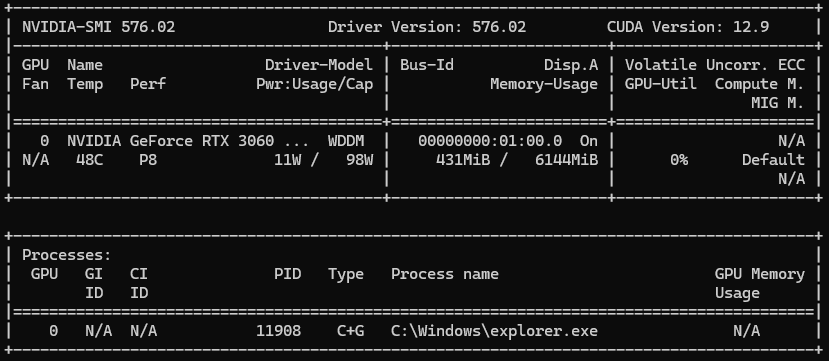

- 윈도우 키 + R

- "cmd" 입력

- "nvidia-smi" 입력(복사, 붙여넣기 또는 복사, 마우스 우클릭 하면 붙여넣기 됩니다.)

드라이버가 있다면 이런 창이 뜰 겁니다.

드라이버가 없다면 아무 정보도 표시되지 않거나

- "NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver"

표시됩니다.

먼저 자신의 그래픽카드(GPU)를 알아봅시다.

- ctrl + alt + del(작업 관리자)

- 상단 또는 좌측 성능 탭에서 "성능" 클릭

- 왼쪽에 GPU 0, GPU 1 이런 항목 클릭

오른쪽에 그래픽카드 정보가 표시됩니다.

또는

- 윈도우 키 + R

- "dxdiag" 입력

- DirectX 진단 도구 창에서:

'디스플레이 1 또는 디스플레이 2' 탭 클릭

-

요즘은 CPU에도 내장 GPU가 있기 때문에,보통 '디스플레이 1'은 내장 GPU, '디스플레이 2'는 외장 GPU가 표시됩니다.

https://www.nvidia.com/ko-kr/drivers/

최신 정식 NVIDIA 드라이버 다운로드

최신 정식 NVIDIA 드라이버를 다운로드하여 PC 게임 경험을 향상시키고 앱을 더 빠르게 실행하세요.

www.nvidia.com

위에 있는 공식 홈페이지에서 자신의 그래픽카드(GPU)에 맞는 드라이버 설치하면 됩니다.

- 제품 유형: 보통 "GeForce" 선택. (서버용 GPU면 "Tesla", 전문가용이면 "Quadro" 선택)

- 제품 시리즈: GPU 이름에 따라 선택. 예: RTX 3060 Laptop이면 "GeForce RTX 30 Series (Notebooks)"

- 제품군: 정확한 GPU 모델 선택. 예: "GeForce RTX 3060 Laptop GPU"

- 운영체제: "Windows 10", "Windows 11" 등 내 OS 선택

- 다운로드 유형: "Game Ready Driver" 추천(최신 게임과 AI 작업 모두 지원)

CUDA Toolkit 설치 전 체크사항

https://en.wikipedia.org/wiki/CUDA#GPUs_supported

CUDA - Wikipedia

From Wikipedia, the free encyclopedia Parallel computing platform and programming model In computing, CUDA (Compute Unified Device Architecture) is a proprietary[2] parallel computing platform and application programming interface (API) that allows softwar

en.wikipedia.org

- 사이트에 들어가서 ctrl + f

예) RTX 3060이면 "rtx 3060" 검색(띄어쓰기해야 검색됩니다) - 밑에 이미지와 같이 자신의 그래픽카드(GPU)에 맞는 CUDA를 확인합니다.

- 좌측 "Compute Capability(version)" 확인

- 제 노트북 사양으로 본다면

RTX 3060(GPU Compute Capability 8.6)은

CUDA (11.1 - 11.4, 11.5 - 11.7, 11.8, 12.0 - 12.6, 12.8) 전부 사용 가능합니다.

https://pytorch.org/get-started/locally/

Start Locally

Start Locally

pytorch.org

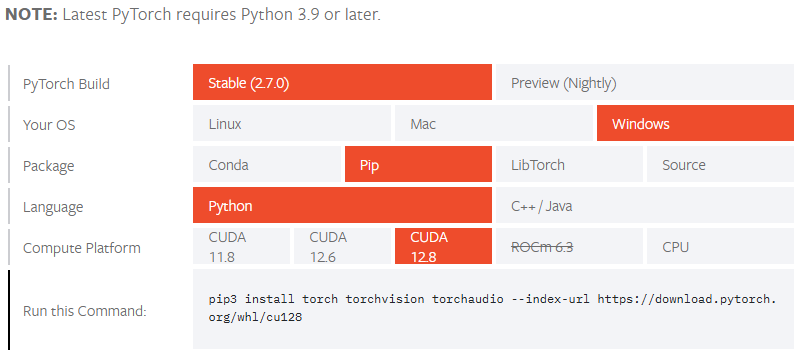

- GPU가 지원하는 CUDA 버전을 확인하는 것도 중요하지만,

PyTorch나 cuDNN이 해당 CUDA 버전을 지원하는지가 가장 중요합니다. - 최신 CUDA가 출시되었다고 해도,

PyTorch에서 아직 해당 버전을 지원하지 않으면

GPU를 제대로 인식하지 못하거나 에러가 발생할 수 있습니다.

아래 X게시물을 확인해 보면

https://x.com/PyTorch/status/1915118946027503736

X의 PyTorch님(@PyTorch)

Update from the PyTorch maintainers: 2.7 is out now. 🔹 Support for NVIDIA Blackwell (CUDA 12.8) 🔹 Mega Cache 🔹 torch.compile for Function Modes 🔹 FlexAttention updates 🔹 Intel GPU perf boost 🔗 Blog: https://t.co/DhwWmcy140 📄 Release no

x.com

2025년 4월 24일에 CUDA 12.8 지원이 추가되었습니다.

- 불과 얼마 전까지만 해도 PyTorch는 CUDA 12.8을 지원하지 않았기 때문에,

그 당시 CUDA 12.8을 설치했다면 GPU 인식 불가 / 작동 오류가 발생했을 수 있습니다. - 따라서, CUDA Toolkit을 설치하기 전에는

반드시 아래 두 가지를 확인해야 합니다:- 내 GPU가 지원하는 CUDA 버전

- PyTorch와 cuDNN이 지원하는 CUDA 버전

- 이 두 조건이 겹치는 버전을 선택해서 설치해야, GPU를 안정적으로 사용할 수 있습니다.

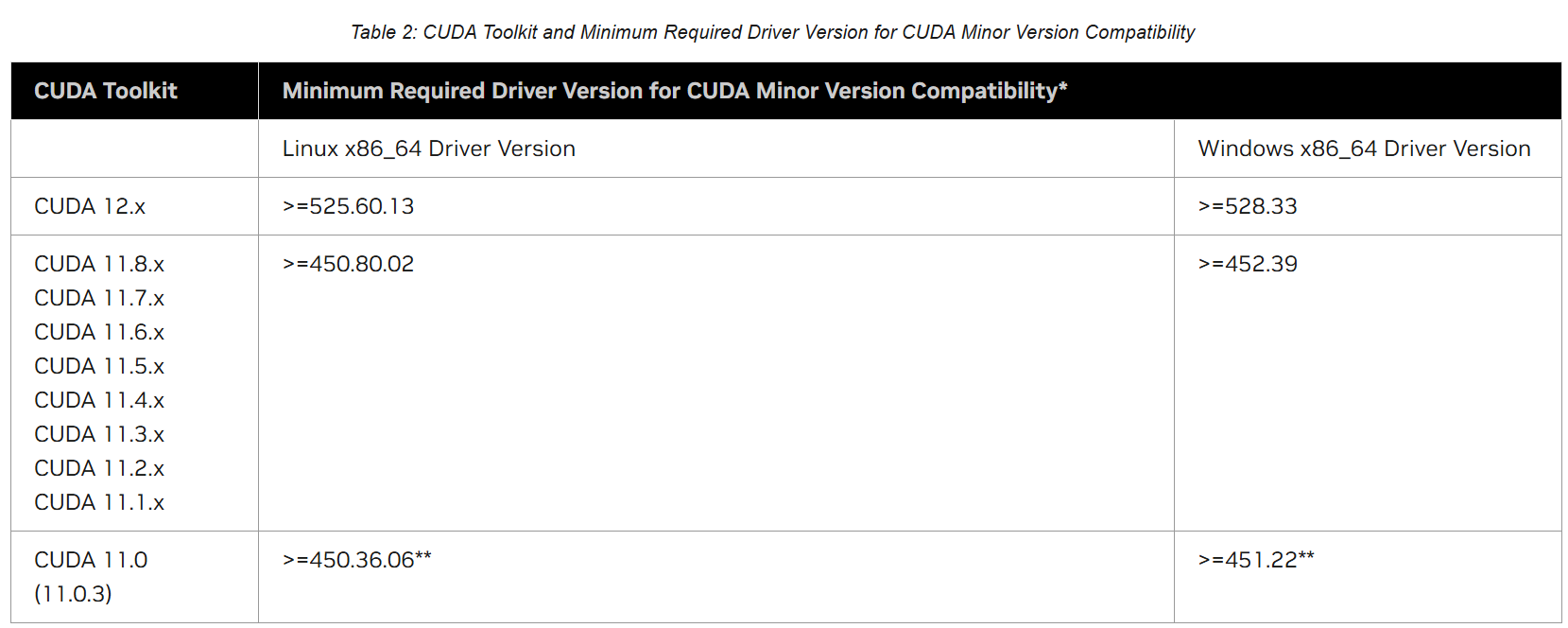

- 또한 CUDA 12.8을 설치하려면, NVIDIA 드라이버 버전이 최소 528.33 이상이어야 합니다.

드라이버가 너무 낮으면 설치는 되어도 제대로 작동하지 않을 수 있습니다.

드라이버 버전은 위에 드라이버 설치 항목 "nvidia-smi"에서 확인할 수 있습니다.

https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html

1. CUDA 12.8 Update 1 Release Notes — Release Notes 12.8 documentation

Using long-deprecated cusolverDnPotrf, cusolverDnPotrs, cusolverDnGeqrf, cusolverDnGetrf, cusolverDnGetrs, cusolverDnSyevd, cusolverDnSyevdx, cusolverDnGesvd, and their accompanying bufferSize functions will result in a deprecation warning. The warning can

docs.nvidia.com

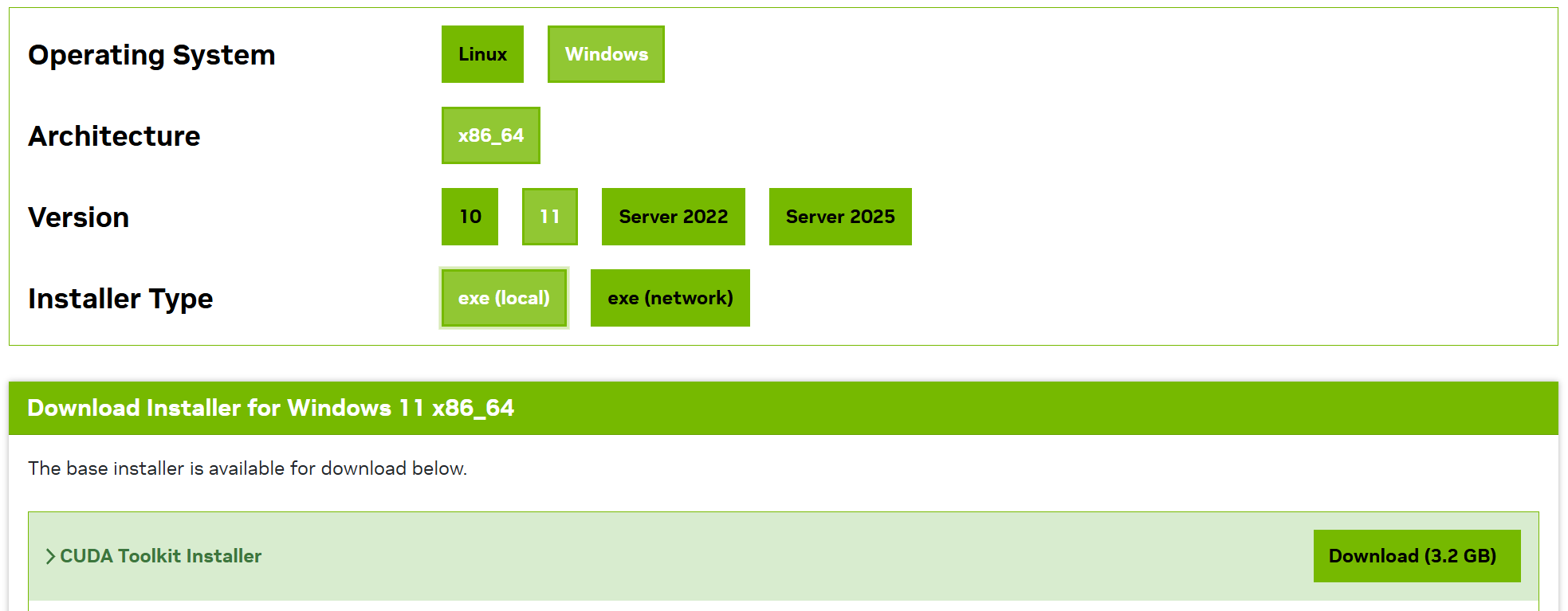

CUDA Toolkit 설치

https://developer.nvidia.com/cuda-toolkit-archive

CUDA Toolkit Archive

Previous releases of the CUDA Toolkit, GPU Computing SDK, documentation and developer drivers can be found using the links below. Please select the release you want from the list below, and be sure to check www.nvidia.com/drivers for more recent production

developer.nvidia.com

- 설치하고자 하는 CUDA Toolkit 버전을 확인하고 설치하면 됩니다.

제 경우는 12.8을 다운로드하였습니다.

- 다운받은 .exe 파일 실행

- "동의 및 계속" 체크

- 보통 "빠른설치(권장)" 선택

특별한 설정이 필요한 경우 "사용자 정의 설치" 선택

(예: 설치 경로 바꾸기, 필요한 컴포넌트만 설치하기 등) - Visual Studio Integration 경고 (옵션)

- 만약 PC에 Visual Studio가 설치 안 되어 있으면

"Visual Studio Integration을 사용할 수 없습니다" 경고가 뜹니다. - 이 경우 그냥 체크박스 체크 후 넘어가면 됩니다.

- Visual Studio 없어도 PyTorch, 딥러닝 사용하는 데는 문제없습니다.

- 만약 PC에 Visual Studio가 설치 안 되어 있으면

cuDNN 설치

https://developer.nvidia.com/cudnn

CUDA Deep Neural Network

cuDNN provides researchers and developers with high-performance GPU acceleration.

developer.nvidia.com

제가 설치할 환경

- CUDA 버전: 12.8

- cuDNN 버전: 9.8

CUDA Toolkit 설치할 때와 마찬가지로,

cuDNN 역시 CUDA 버전에 맞는 버전을 선택해야 합니다.

- CUDA 12.8 ➔ cuDNN 9.0 이상 필요

- 저는 cuDNN 9.8 설치할 예정입니다.

- 자신의 CUDA 버전에 맞는 cuDNN이 없으면,

NVIDIA cuDNN Archive에서 과거 버전을 찾아야 합니다.

https://developer.nvidia.com/rdp/cudnn-archive

cuDNN Archive

Download releases from the GPU-accelerated primitive library for deep neural networks.

developer.nvidia.com

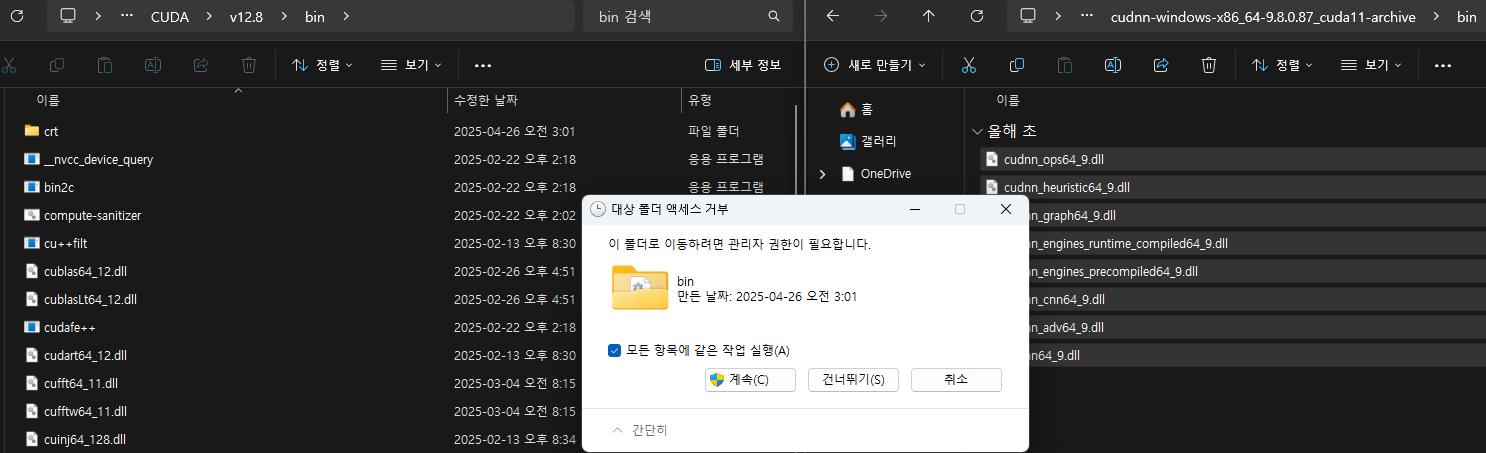

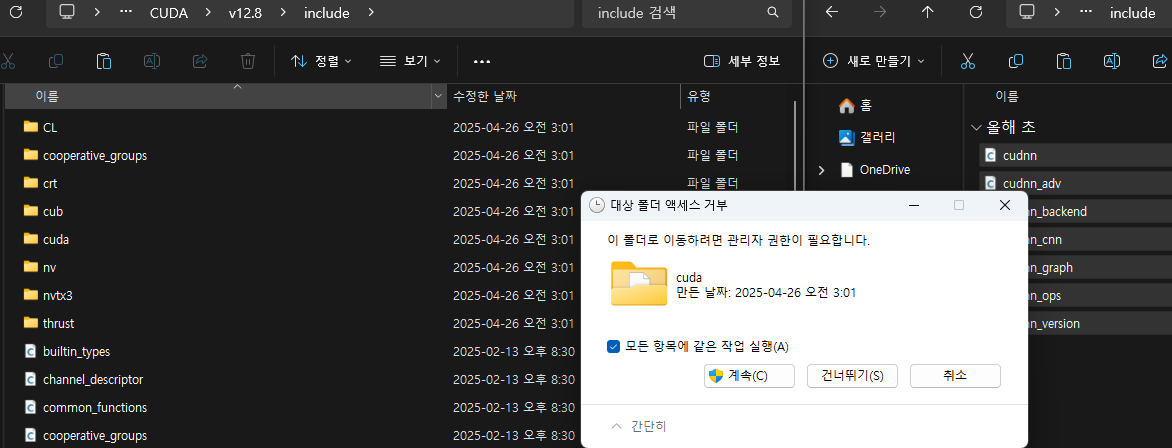

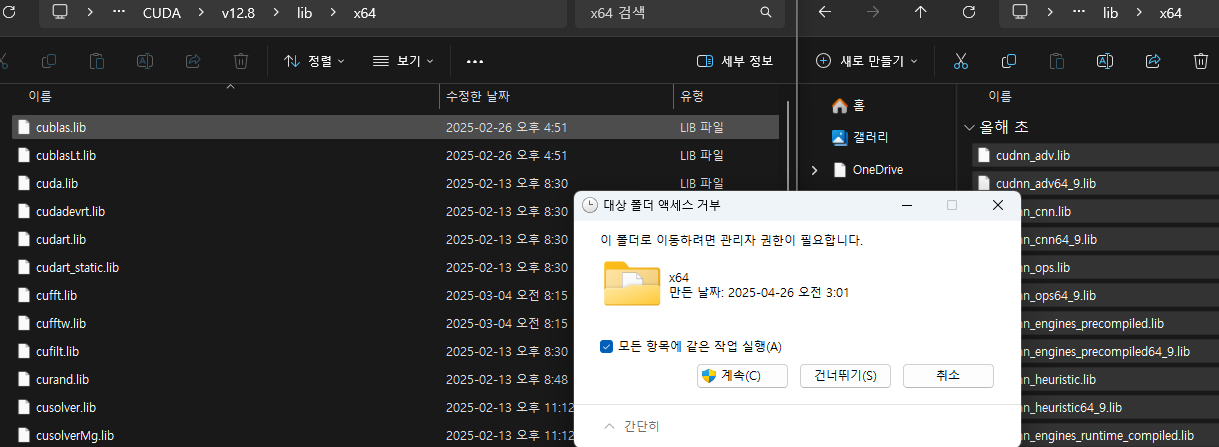

cuDNN 압축 해제

- 다운받은 zip 파일 압축 풀기

- 폴더 안에는 다음 3개 디렉토리가 있습니다.

- bin

- include

- lib

cuDNN 복사

- 압축을 푼 후, 각 파일을 CUDA 설치 경로에 붙여넣기 합니다.

| bin 폴더 | C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\bin |

| include 폴더 | C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\include |

| lib 폴더 | C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\lib\x64 |

폴더 구조를 헷갈리지 않게 주의 바랍니다.

- cuDNN은 따로 설치 프로그램(exe)이 없습니다.

- 파일 복사로 설치가 끝입니다.

CUDA 환경변수 설정 체크

- CUDA Toolkit을 설치했어도,

Windows가 CUDA 경로를 모르면

PyTorch나 다른 프로그램들이 GPU를 사용할 수 없습니다. - 설정이 되어있을 텐데 확인하는 작업이 필요합니다.

- 윈도우 키

- Windows 검색창에 "환경 변수" 검색

- "시스템 환경 변수 편집" 클릭

- '고급 탭' - "환경 변수" 클릭

만약 설정이 안 되어 있다면

- 시스템 변수에서 Path 선택 ➔ [편집]

- 새로 만들기

밑에 있는 경로 붙여넣기(CUDA 버전이 다르면 버전 수정해야 합니다.) - 또는

찾아보기로 아래에 있는 경로 설정해 주면 됩니다.

( 아래는 CUDA 12.8 기준입니다, 버전이 다르면 v12.8 부분을 자신의 버전에 맞게 변경해야합니다.)

| C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\bin | CUDA 실행파일 경로 |

| C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\libnvvp | CUDA Visual Profiler 경로 (디버깅용) |

- Path에 경로 추가할 때 기존 내용을 절대 지우면 안 됩니다!

(기존 값에 추가만 해야 합니다.) - 경로 복붙할 때 띄어쓰기, 오타 조심해야 합니다.

환경변수 설정이 잘 되었는지 확인

- 윈도우 키 + R

- "cmd" 입력

- "nvcc --version" 입력 엔터

- CUDA 버전이 정상적으로 출력되면 성공입니다.

파이썬 3.9 또는 3.10 버전을 설치한 후 진행하면 됩니다.

최신 버전인 3.13은 일부 라이브러리들과 호환 문제가 발생할 수 있습니다.

(참고로 저는 파이썬 3.9.13 버전을 사용하고 있습니다.)

PyTorch 설치 전 가상환경을 설정할 예정이라면

밑에 있는 가상환경 설정 후 PyTorch 설치하면 됩니다.

PyTorch 설치

- 이제 CUDA Toolkit 12.8, cuDNN 9.8 설치가 완료되었으니,

드디어 PyTorch를 설치해서 딥러닝 환경을 완성해 보겠습니다.

https://pytorch.org/get-started/locally/

Start Locally

Start Locally

pytorch.org

제 경우는 Python 3.9.13을 설치했습니다.

- VSCode 터미널에서

- "python --version" 입력

자신의 파이썬 버전을 확인할 수 있습니다.

위에 있는 PyTorch 공식사이트에서 맞는 CUDA 클릭 후

"Run this Command:"항목을 복사하여 터미널에서 입력 후 설치하면 됩니다.

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128- 이 명령어는 PyTorch, torchvision, torchaudio를 한 번에 설치합니다.

- VSCode 터미널에서 가상환경이 활성화된 상태로 위 명령어를 실행

- 설치가 완료될 때까지 기다립니다.

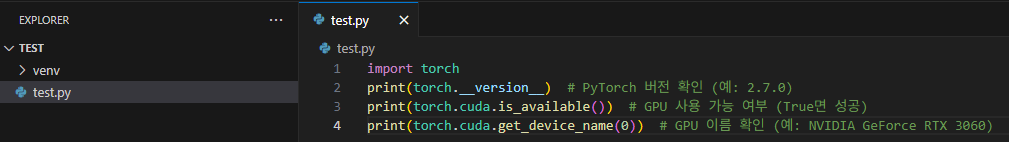

설치 확인

import torch

print(torch.__version__)

print(torch.cuda.is_available())

print(torch.cuda.get_device_name(0))

- test.py파일을 만들거나 파이썬 파일을 따로 만듭니다.

- 위에 있는 코드를 복사, 붙여넣기 후 파일을 실행해 GPU 사용 가능 여부를 확인합니다.

-

2.7.0

-

True

-

NVIDIA GeForce RTX 3060

위와 같이 True가 출력되면 PyTorch 설치가 정상적으로 완료된 것입니다.

가상환경이란?

-

공용 공간 = 컴퓨터 시스템

모든 가족(프로젝트)이 공용 주방(시스템의 파이썬 및 라이브러리)을 공유합니다.

예를 들어, 주방에는 하나의 냉장고(파이썬 인터프리터)와 재료(라이브러리)만 있어서, 모두가 동일한 자원을 사용해야 합니다. - 문제점:

한 가족 구성원(프로젝트)이 주방에서 재료(라이브러리 버전)를 바꾸거나, 설거지를 하지 않고 어지럽히면(충돌 발생), 다른 가족의 요리(다른 프로젝트)에도 영향을 미칩니다.

예를 들어, 한 프로젝트에서 numpy를 최신 버전으로 업그레이드하면,

다른 프로젝트가 호환되지 않는 경우 오류가 발생할 수 있습니다. - 결과:

모든 프로젝트가 동일한 라이브러리와 설정을 공유하므로,

한 프로젝트에서 생긴 변경 사항이 다른 프로젝트를 망가뜨릴 위험이 큽니다.

가상환경이 있는 환경: 기숙사(venv, Anaconda)

- 내 방 = 가상환경:

각 프로젝트는 독립된 방(가상환경)을 가지며,

이곳에 자신만의 파이썬 인터프리터와 라이브러리를 설치합니다.

내 방에서 사용하는 재료(라이브러리)는 다른 방(다른 가상환경)과 완전히 분리되어 있어, 서로 영향을 주지 않습니다. - 공용 공간 = 시스템 자원:

기숙사에는 공용 화장실이나 주방(시스템의 기본 파이썬, 시스템 파일)이 있어 모든 가상환경이 이를 공유합니다.

하지만 각 방의 물건(라이브러리와 설정)은 독립적으로 관리됩니다. - 결과:

한 프로젝트에서 라이브러리 버전을 변경하거나 새로운 라이브러리를 설치해도,

다른 프로젝트의 가상환경에는 전혀 영향을 미치지 않습니다.

마치 기숙사에서 내 방을 어떻게 꾸미든 다른 방에는 상관없는 것과 같습니다.

가상환경 설정: Venv로 설정하기

- venv는 Python에 기본으로 포함된 가상환경 도구입니다.

Anaconda처럼 추가 설치가 필요 없고, 가볍게 사용할 수 있습니다.

- venv는 Python이 설치되어 있으면 바로 사용할 수 있습니다.

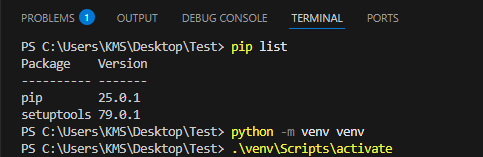

- 터미널에서 아래 명령어를 입력합니다.

터미널은 상단 Teminal - New Terminal 클릭

python -m venv venv명령어를 실행하면 현재 폴더 안에 venv라는 이름의 가상환경 폴더가 생성됩니다.

'venv' 뒤에 오는 이름은 자유지만, 보통 그냥 'venv'라고 많이 합니다.

venv 활성화하기

생성한 가상환경을 활성화하려면 아래 명령어를 입력합니다.

.\venv\Scripts\activate

여기서 "Scripts" 오류발생 시

아래 명령어를 입력합니다.

Set-ExecutionPolicy -Scope Process -ExecutionPolicy Bypass입력 후 활성화 코드(".\venv\Scripts\activate")를 입력하면 됩니다.

활성화하게 되면 뒤에 (venv)가 붙습니다.

이대로 PyTorch를 설치해도 되지만

아래에 명령어를 입력하여 pip 및 setuptools 업그레이드 후 설치 권장합니다.

python -m pip install --upgrade pip

pip install --upgrade setuptools하나씩 입력 후 실행

- 새 가상환경을 선택하면 VSCode가 자동으로 터미널에서 활성화(.venv 또는 myenv 표시)합니다.

- 이제 현재 가상환경에서 설치한 라이브러리는 다른 프로젝트에 영향을 주지 않습니다.

Conda는 나중에 가상환경에 대해 자세히 다룰 때 설정해 보겠습니다.

추가 질문이나 특정 오류 메시지가 있으면 댓글로 남겨주시면 됩니다.

감사합니다.